«El lado oscuro del algoritmo»

Tras relativizar la mentada eficiencia de los beneficios de los algoritmos, Alejandro Marcó del Pont, advirtió que estos artilugios "son para los que piensan, no para los que lo ejecutan".

- Conclusión en Buenos Aires

- Oct 31, 2023

Por Alejandro Marcó del Pont

Algoritmo, una palabra para que los errores de los programadores sean aceptables

Vivimos en la época de los algoritmos. Las decisiones que afectan a nuestras vidas no están hechas por humanos, sino por modelos matemáticos. Estos esquemas se diseñaron para permitirnos, entre otras cosas, ahorrar tiempo, pero además se los popularizó como procesos más justos y objetivos. Antes estas técnicas la resolvían seres humanos, trabajadores ineficientes, según el progreso por estar dotados de un cúmulo de problemas: familia, horarios, prejuicios, arbitrariedades, etcétera, escarbando en montaña de papel para obtener un ¡deficiente! resultado.

Gracias a estos imperdonables e inútiles resultados nos vendieron la innovación, programas de computadora capaces de procesar miles de datos de manera rápida e “imparcial”. Nadie sabe bien cuál es el objetivo del progreso, ni cuál la prisa, menos aún la necesidad imperiosa del avance tecnológico. Como decía Hegel, “Tengan cuidado, hombres de acción, porque ustedes son meros instrumentos de los hombres de pensamiento”, y claramente la mayoría no está entre estos últimos. Los beneficios de los algoritmos son para los que piensan, no para los que lo ejecutan.

Para tratar de optimizar algo, reducir la incertidumbre, predecir el futuro, transformar plomo en oro, se ha echado mano a una antigua disciplina filosófica que combina elementos, la tan mentada alquimia, que en la actualidad, y dada la modernidad, su nombre mutó al de “modelos matemáticos”. Estos pueden ser opacos, oscuros e irrefutables, sobre todo esto último, yo diría incuestionables, incluso cuando están equivocados, pero esa es una de sus mayores virtudes. Lo más llamativo es, aunque la gente no lo sepa, que apuntalan a los afortunados y castigan a los oprimidos: bienvenido al lado oscuro del big data.

Georg Friedrich Hegel (27 de agosto de 1770 – 14 de noviembre de 1831),

La matemática Caty O’Neil nos presenta los modelos que dan forma a nuestro futuro, no solo como individuos sino como sociedad. Estas “armas de destrucción matemática”, como titula su libro, califican a maestros y estudiantes, ordenan currículos, niegan préstamos, evalúan a los trabajadores, dirigen a los votantes, monitorean nuestra salud, las redes sociales y las inversiones, entre otras cosas. Gracias a los extraordinarios poderes de las matemáticas combinados con la tecnología pueden de manera científica multiplicar el caos y la desgracia y promoverse con casi nula controversia como: provechosa.

Uno podría pensar que esta mujer es algún tipo de apostata de la modernidad, pero no es así. Fue profesora de universidad de Barnard College, que compartía con la Universidad de Columbia el departamento de Matemáticas. Decidió cambiar radicalmente su carrera profesional y comenzó a trabajar como analista cuantitativa para D. E. Shaw, un destacado fondo de cobertura. Con el tiempo, y con la crisis del 2008, entendió que se afianzaba un mal uso de las matemáticas, los algoritmos se ponían más de moda y se extendían a un creciente número de áreas. Comprendió que funcionaban veinticuatro horas al día procesando inmensas cantidades de información, en gran parte datos extraídos de las redes sociales o de páginas web, como dejamos expuesto en el artículo Big Tech, el dominio de la economía del siglo XXX.

En lugar de prestar atención a los movimientos de los mercados financieros mundiales, se dedicaban cada vez más a analizar a los seres humanos. Los matemáticos y los especialistas en estadísticas estudiaban nuestros deseos, nuestros movimientos y nuestro poder adquisitivo. Predecían nuestra solvencia y calculaban nuestro potencial como estudiantes, trabajadores, amantes o delincuentes. Esta era la economía del big data, y prometía ganancias espectaculares.

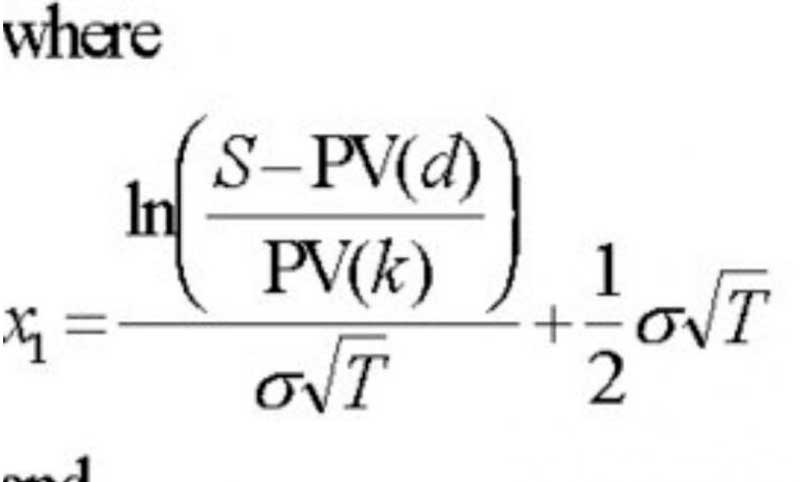

En 1997, el Banco Central sueco concedió el premio a las ciencias económicas en honor a Nobel, a Myron Scholes y Robert C. Merton por “un nuevo método para determinar el valor de los derivados”. Por cierto, un derivado es un producto financiero cuyo precio parte del precio de otro activo, futuros del petróleo, por ejemplo, y dependen del valor del activo principal, el barril de petróleo.

Estos señores habían fundado tres años antes –junto con John Meriwether, antiguo vicepresidente de Salomon Brothers– un fondo de inversión de carácter especulativo, Long Term Capital Management o LTCM. ¿Se acuerdan de él? Obtuvo elevados rendimientos en los primeros años, por lo que todo el mundo los consideraba unos genios. Pero en 1998, sus modelos de riesgo se fueron al garete: el fondo perdió 4.600 millones de dólares en menos de cuatro meses, provocando la intervención de la Reserva Federal de los Estados Unidos, el rescate por otras entidades financieras y el cierre a comienzos de 2000.

La ecuación matemática de Scholes y Merton que derrumbo el mundo financiero

En el 2019, un estudio publicado en la revista Science reveló que era mucho menos probable que un algoritmo de predicción de atención médica, utilizado por hospitales y compañías de seguros en los EE. UU. para identificar a los pacientes que necesitaban programas de “gestión de la atención de alto riesgo», fueran afroamericanos. En cambio, el algoritmo recomendaría pacientes blancos para estos programas y no a pacientes negros. El estudio encontró que el algoritmo usaba el gasto en atención médica como un indicador para determinar la necesidad de atención médica o el puntaje de un individuo, lo que anulaba, para obviar largas razones, a hombres y mujeres de color.

Como se ve, trabajos, inversiones y salud, al menos con los ejemplos expuestos arriba, están condenados por los algoritmos. Pero la idea es que entendamos cómo se fabrica el modelo y así comprender lo que sucede. El ejemplo que da en su libro Caty O’Neil es muy ilustrativo y simpático. Sería como diseñar la estructura de cómo detener a Messi, pero en beisbol, un deporte que deja marcas más fáciles de explicar y no el regateo que puede tener el mediocampista, y cuya tendencia es indeterminada.

Antes de comenzar quisiera destacar una aclaración que da la misma autora, y es que el cerebro humano realiza las mismas tareas que un algoritmo. Ella da una explicación acerca de la preparación de la cena para sus tres hijos, lo que expone un modelo informal de algoritmo cerebral que como madre emplea a diario. Cada noche, cuando se pone a cocinar de manera intuitiva, piensa recabando información cuánto apetito tendrá cada uno de los miembros de mi familia. Sabe además que uno de sus hijos comerá solo la pasta, que el otro comerá pollo y el último es fanático de las hamburguesas. Los datos de entrada del modelo son la información que tiene sobre su familia, los ingredientes que tiene en la cocina, el tiempo, las ganas, etc. La evaluación del éxito será cuánto cenen o cuánto dejen. El problema radica en su ausencia, si ella sale y sus hijos se quedan con la abuela, ¿se puede transmitir el algoritmo, toda la información obtenida en él para que la abuela haga la cena?, la verdad, no.

Para afianzar este punto enfoquémonos en cómo hacer para parar a un jugador específico en el beisbol. Un equipo cambio de posición a sus jugadores porque descubrió que la tendencia de bateo de quien les había hecho daño en el primer partido era la misma, siempre al mismo lugar, siempre a la derecha, supongamos, así que puso a su mejor jugador a la derecha para que atrapara los batazos del contrario. En la actualidad todos los equipos lo hacen, de hecho, el algoritmo se va nutriendo con las estadísticas de cada bateo, de cada juego. Y todas las preguntas que se nos ocurren son las que nutren el modelo. La respuesta del modelo es ejecutar diferentes escenarios en cada coyuntura para dar con las combinaciones de respuestas óptimas en cada instancia del partido. El problema está en las preguntas que lo alimentan.

Si las respuestas son los gastos en salud y estos gastos dan puntajes para ingresar a ciertos programas, los afroamericanos que no gastan en salud, por no tener recursos, harán que el algoritmo los deje fuera, porque se nutre de gastos para decidir y brindar puntaje, es decir, el diseño de las variables que nutre las estadísticas está pensado para dejarlos fuera. Eso sí, de manera matemáticamente justificada, imparcial y científica. Y aquí está el centro de la mentira y ella da un ejemplo en el que señala sus características destructivas poco a poco.

Limitan al acceso a servicios de salud y planes médicos a pacientes negros en EE.UU.

El nuevo alcalde de Washington decidió corregir la situación de las escuelas deficientes de la ciudad, las que tenían malos alumnos, de los cuales muy pocos llegaban a graduarse del primario. La teoría generalmente aceptada por el neoliberalismo era que los alumnos no aprendían lo suficiente porque sus profesores no trabajaban bien. De modo que, en 2009 se planteó un plan para extirpar del sistema a los docentes de bajo rendimiento. ¿Cómo?, pues evaluando a los profesores con una prueba llamada IMPACT, deshacerse de los peores y colocar a los mejores donde se pueda producir el mayor efecto positivo posible.

Una de las evaluadas era Sarah Wysocki, maestra de quinto grado, que llevaba trabajando solo dos años en el colegio MacFarland, pero el director del colegio y los padres de sus alumnos tenían ya una excelente opinión de ella. Elogiaban lo atenta que era con los niños; “una de las mejores maestras con las que he tratado nunca”. La maestra Wysocki sacó una penosa puntuación en su evaluación de IMPACT, esa puntuación, generada por un algoritmo, la dejaba debajo del umbral mínimo, por lo que ella y 205 maestros más fueron despedidos. Obviamente, Sarah Wysocki pensó que los números eran terriblemente injustos y quiso saber de dónde venían.

¿Cómo estaba diseñado el algoritmo?, ¿qué lo nutria? Bien, el primer problema fue que la ciudad contrató una consultora que tenía un sistema llamado Mathematica y dicha consultora no podía revelar su formato, porque la habían contratado porque tenía el conocimiento para hacer la evaluación. El modelo en sí es una caja negra, su contenido, un secreto corporativo fieramente guardado. De este modo, las consultoras con sistemas como Mathematica pueden cobrar más, aunque este secretismo sirve también a otros propósitos. Intentar puntuar la eficacia de un docente analizando los resultados de una prueba de solo veinticinco o treinta alumnos no tiene solidez estadística y es, incluso, ridículo. Pero ¿cómo puede confirmar el sistema que su análisis fue correcto? No puede. Una de las variables que alimentaba al algoritmo era los resultados de años anteriores. En ellos los docentes ayudaron a sus alumnos a realizar pruebas para que el establecimiento quedara bien parado; con esta profesora, eso no pasó.

Lo que nutre el algoritmo es lo que se llama “bucle de retroalimentación” Las empresas, por ejemplo, utilizan cada vez más las calificaciones de solvencia crediticia para evaluar a los posibles candidatos para un trabajo. Se basan en la creencia de que las personas que pagan pronto sus facturas tienen más probabilidades de llegar puntualmente a su puesto de trabajo y de cumplir las normas. Pero buenos trabajadores tuvieron la desgracia de quedarse desempleados porque su empresa cerró, por lo que tardan en pagar facturas, lo que hace que tengan una mala calificación crediticia. No obstante, esta idea de que dicha mala calificación está relacionada con un mal rendimiento en el trabajo hace que las personas que tienen una calificación más baja tengan menos probabilidades de encontrar trabajo. El desempleo los empuja a la pobreza, lo que a su vez empeora aún más sus calificaciones de solvencia, con lo que les resulta aún más difícil encontrar trabajo.

Desocupados

Un algoritmo procesa un montón de estadísticas y produce como resultado una cierta probabilidad de que una persona concreta pueda ser un mal empleado, un prestatario de riesgo, un terrorista o un pésimo maestro. Esa probabilidad se condensa en una puntuación, que puede llegar a destrozar la vida de alguien. Y, sin embargo, cuando esa persona decide defenderse, las “sugerentes” pruebas en contra del veredicto son insuficientes para aclarar las cosas.

Después de la terrible sorpresa de su despido, Sarah Wysocki solo estuvo unos cuantos días desempleada. Había mucha gente dispuesta a responder por su trabajo como maestra, entre ellas su director, y en seguida la contrataron en un colegio privado de un próspero distrito al norte de Virginia. La consecuencia final fue que, gracias a un modelo altamente cuestionable, un colegio pobre perdió a una buena maestra, y un colegio rico, que no despedía a los docentes por las puntuaciones que obtuvieran sus alumnos, ganó una.